AMY GOODMAN: Este es el la Democracia Ahora!, democracynow.org, La Guerra y la Paz Informe. Soy Amy Goodman, con Nermeen Shaikh. Y estamos transmitiendo desde el Festival de Cine de Sundance en Park City, Utah, desde el Parque de la TELEVISIÓN de la Ciudad, donde una nueva película se ve en la raza y los prejuicios de género al horno en tecnología de inteligencia artificial, como el reconocimiento facial. La película se llama Codificado Sesgo.

NERMEEN SHAIKH: a principios de este mes, en Cambridge, Massachusetts, votó a favor de la prohibición de reconocimiento facial, unirse a un creciente número de ciudades en los estados UNIDOS, como San Francisco, que han prohibido la inteligencia artificial de software, citando defectuosa de la tecnología.

AMY GOODMAN: Un estudio reciente encontró que el reconocimiento facial identificado los Afro-Americanos y Asiáticos caras incorrectamente 10 a 100 veces más que los blancos rostros. El estudio realizado por el Instituto Nacional de Estándares y Tecnología encontrado una foto de la base de datos utilizada por la aplicación de la ley incorrectamente identificado los Nativos Americanos en las tarifas más altas.

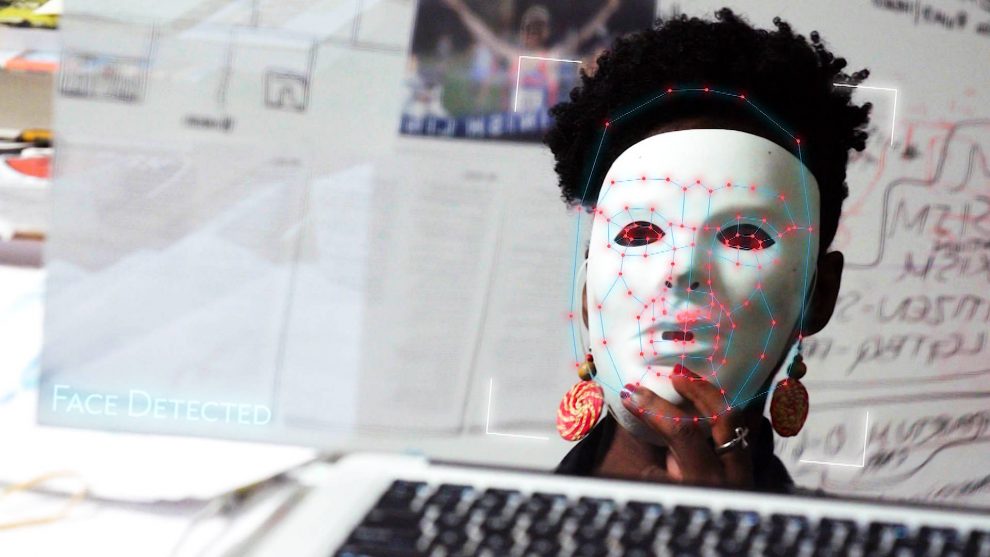

NERMEEN SHAIKH: El peligro de una errónea inteligencia artificial y su creciente omnipresencia en la vida cotidiana es el enfoque de la nueva película de Codificado Sesgo. La película comienza con Alegría Buolamwini, un investigador en el MIT Laboratorio de Medios de comunicación, que descubre que la mayoría de los software de reconocimiento facial no reconoce piel más oscura o de rostros femeninos cuando ella tiene que usar una máscara blanca, para ser reconocida por un robot que ella misma es la programación. Ella va a revelar que la inteligencia artificial no es en realidad un neutral herramienta científica, sino que refleja los prejuicios y las desigualdades de la sociedad en general.

AMY GOODMAN: Esta es la Alegría Buolamwini testificando ante el Congreso en Mayo.

ALEGRÍA BUOLAMWINI: soy un algoritmo sesgo del investigador basado en MIT, y he llevado a cabo estudios que muestran que algunos de la más grande registrada racial de la piel y tipo de sesgos en la IA de los sistemas vendidos por las empresas como IBM, Microsoft y Amazon. Ya has escuchado hablar de reconocimiento facial y de tecnologías relacionadas, tienen algunas fallas. En una prueba que se corrió, Amazon reconocimiento incluso falló en la cara de Oprah Winfrey, el etiquetado de sus hombres. Personalmente, he tenido que recurrir a, literalmente, que llevaba una máscara blanca para tener mi cara detectada por algunos de esta tecnología. La codificación en la cara blanca es la última cosa que debe hacer en MIT, un Estadounidense epicentro de la innovación.

Ahora bien, dado el uso de esta tecnología para la masa de la vigilancia, no teniendo mi rostro detectado podría ser visto como un beneficio. Pero además de ser empleado para la dispensación de papel higiénico, en China la tecnología está siendo utilizado para el seguimiento de la minoría Musulmana Uigur. Más allá de ser abusados, hay muchas maneras para que esta tecnología a fallar. Entre las más urgentes son errores de identificación que puede llevar a la falsa detención y acusaciones. … La confusión de identidad es más que un inconveniente y puede conducir a graves consecuencias.

AMY GOODMAN: Que la Alegría Buolamwini, que ahora se une a nosotros aquí en el Parque de la Ciudad en el Festival de Cine de Sundance, junto con Shalini Kantayya, el director de la película Codificado Sesgo, que se estrenó aquí en el festival de cine.

Le damos la bienvenida tanto a la Democracia Ahora!, por Lo tanto, partir de ahí, la Alegría. Quiero decir, ¿cómo fue que empezaste a testificar ante el Congreso? Y nos llevará en su viaje, desde el MIT, el descubrimiento de que su rostro es uno que sería reconocido tantas veces menos que cuando la inteligencia artificial se utiliza la tecnología de otros. Quiero decir, tal vez que una protección. Quién sabe?

ALEGRÍA BUOLAMWINI: Absolutamente. Por lo tanto, mi viaje comenzó como estudiante de posgrado. Yo estaba trabajando en un proyecto de arte que utiliza tecnología de detección de rostros, y me encontré con que no detecta mi cara que bien, hasta que me puse una máscara blanca. Y así, fue que el blanco de la máscara de experiencia que condujo a un cuestionamiento: żcómo hacemos para ver los equipos en el primer lugar? Cómo es la inteligencia artificial que se está usando? Y si mi cara no está siendo detectado en este contexto, es sólo a mí o a otras personas?

AMY GOODMAN: Puede también paso atrás? Lo que hace la inteligencia artificial significa? Lo que hace AI significa?

ALEGRÍA BUOLAMWINI: Seguro. Así, AI se trata de dar a las máquinas de lo que percibimos a ser un poco inteligente desde una perspectiva humana. Así, esto puede ser alrededor de percibir el mundo, de modo que la visión por computador, dando a los equipos de los ojos. Puede ser de reconocimiento de voz. También puede ser sobre la comunicación. Por lo tanto, pensar acerca de los chatbots, ¿verdad? O pensar en hablar a Siri o Alexa. Y luego, otro componente de la inteligencia artificial es acerca de discernimiento o hacer juicios de valor. Y esto puede llegar a ser muy peligroso, si usted está decidiendo qué tan riesgoso alguien es o si debe ser contratado o despedido, debido a que estas decisiones pueden afectar la vida de las personas en una forma material.

NERMEEN SHAIKH: Así, se puede hablar de los orígenes de la inteligencia artificial? Usted va sobre él un poco en la película Codificado Sesgo.

ALEGRÍA BUOLAMWINI: Sí. Y Shalini hace un gran trabajo de realmente tomar todo el camino de vuelta a Dartmouth, donde había un grupo de los que yo llamo cariñosamente pálido “machos” que vienen juntos para decidir lo que la inteligencia podría parecer. Y aquí usted está diciendo, “Si usted puede jugar al ajedrez bueno, eso es algo que se parece a la inteligencia”. La cosa también acerca de la inteligencia artificial es lo que se cambia. Así, cuando las máquinas se consigue mejor en tipos específicos de tareas, usted podría decir, “Oh, eso no es realmente la inteligencia.” Así, es un movimiento de la línea.

AMY GOODMAN:, por Lo tanto, Shalini, ¿por qué no hablar de cómo se le ocurrió la idea de Codificado Sesgo, de Alegría, de una figura central, por supuesto, de esta película, y tomar la historia más?

SHALINI KANTAYYA: Bueno, básicamente, que era como una especie de fanático de la ciencia ficción. Y por eso me gusta leer acerca de la tecnología y de imaginar el futuro. Y creo que mucho de lo que pensamos acerca de la inteligencia artificial proviene de la ciencia ficción. Es una especie de las cosas de la Blade Runner y El Terminador. Y luego, cuando empecé a ordenar de leer y escuchar a TED Charlas de Alegría y otro matemático llamada Cathy O’Neil, otras mujeres como Meredith Broussard y Zeynep Tufekci, me di cuenta de que la inteligencia artificial era algo totalmente diferente en el ahora. Se estaba convirtiendo en un portero, haciendo automatizado de las decisiones acerca de quién es contratado, que se pone de salud y que se mete en la universidad. Y cuando descubrí la Alegría del trabajo, yo estaba cautivado por esta joven, que estaba interrumpiendo el perturbadores.

AMY GOODMAN:, por Lo tanto, vamos a ir a un clip de la notable película, Codificado Sesgo. Esto demuestra la policía en Londres la detención de un joven negro adolescente.

SILKIE: dime lo que está pasando.

GRIFF la NORIA: Este joven negro del chico con el uniforme escolar, pararon como resultado de un partido. Le tomó por esa calle sólo para un lado y como muy bien buscado él. Fue a todos los policías de civil, así. Fue cuatro policías de civil que le detuvo. Las huellas digitales de él después de unos como tal vez 10, 15 minutos de búsqueda y comprobación de sus datos y la toma de huellas de él. Y se volvió y dijo que no es él.

disculpe. Yo trabajo para una de derechos humanos de la organización de campañas. Estamos haciendo campaña en contra de la tecnología de reconocimiento facial. Estamos en campaña contra facial — estamos llamados Big Brother Watch. Somos una de derechos humanos de la organización de campañas. Estamos haciendo campaña en contra de esta tecnología hoy aquí. Y, a continuación, usted ha sido detenido a causa de eso. Que erróneamente usted. Y estos son los detalles aquí.

Él estaba un poco agitado. Sus amigos estaban allí. No podía creer lo que le había sucedido a él.

sí, Sí. Usted ha sido erróneamente identificado por sus sistemas, Y se ha detenido y la utilizó como justificación para detener y búsqueda.

Pero esto es un inocente, joven de 14 años de edad, niño que ha sido detenido por la policía como resultado de un reconocimiento facial de identificación errónea.

AMY GOODMAN:, por Lo tanto, que es un clip de Codificado Sesgo. La alegría Buolamwini, explicar con más detalle lo que ocurrió aquí, la identificación errónea, la identificación. Algunos podrían perversamente dicen que es mejor para esta tecnología a fallar, así que la gente no puede ser identificado, pero este es el caso contrario.

ALEGRÍA BUOLAMWINI: Absolutamente. Así que usted decía antes tal vez no ser identificado es una buena cosa. Pero luego están los errores de identificación que tienen un real impacto en el mundo. Así, en el clip y en el cine, de ver realmente el trabajo de Big Brother Watch reino unido Y en este escenario en particular, Big Brother Watch reino unido fue capaz de seguir la pista de lo que estaba pasando en Londres. Y una de las cosas que mostraron en su estudio, “Face Off”, era falso positivo coincidir con tasas de más del 90%. Así que usted puede ver el ejemplo aquí, sino que también había los informes donde más de 2.400 personas inocentes fueron coincidentes. Así que no es sólo un caso de, “Oh, usted no es detectado.” Que puede ser a veces. Pero usted podría ser identificado erróneamente como alguien que no eres, y las consecuencias pueden ser graves.

AMY GOODMAN: Y vamos a jugar este clip en un momento en The New York Times informes de Londres el Departamento de Policía de Londres del Departamento de Policía dijo que iba a empezar a utilizar el reconocimiento facial para detectar a los sospechosos de crímenes con cámaras de video, ya que caminar por las calles, la adopción de un nivel de vigilancia que es raro fuera de China, la tecnología de la implementación de Londres va más allá de muchos de los sistemas de reconocimiento facial utilizada en otras partes, que coinciden con una foto en contra de una base de datos. La nueva tecnología utiliza un software que puede identificar de inmediato la gente en un policía de la lista de seguimiento tan pronto como estén filmado en una cámara de vídeo, la Alegría.

ALEGRÍA BUOLAMWINI: Y creo que usted puede ser que necesite para decir “intento de identificar,” porque a menudo lo que se dice acerca de estas tecnologías no corresponden necesariamente a la realidad. Anteriormente se habló sobre el Instituto Nacional de Estándares y Tecnología de estudio. Ellos estudiaron a más de 189 algoritmos de 99 empresas diferentes. Y así, esta es la mayoría de la tecnología de reconocimiento facial que hay ahí fuera — los prejuicios raciales, los prejuicios de género, edad sesgo, así. Por lo tanto, si usted tiene una cara, tiene un lugar en esta conversación, y todos tenemos que estar preocupados. Así que creo que es muy irresponsable para implementar tecnologías que ya sabemos que tiene fallas importantes, que ya sabemos que puede ser objeto de abuso. Es de sentido común para establecer una moratoria hasta que no estamos en un lugar mejor.

NERMEEN SHAIKH: Bueno, Shalini, otro lugar que usted perfil en el documental es el de China. Y puedes hablar a esta mujer en un poco de longitud. Así que, un par de preguntas. En primer lugar, ¿cómo acceder? Y su respuesta al hecho de que ella en realidad con el apoyo del crédito — ¿qué es? El sistema de crédito social?

SHALINI KANTAYYA: Absolutamente.

NERMEEN SHAIKH: Si usted pudiera explicar lo que es, cómo funciona y cuál es su sentido es de la clase de apoyo que este sistema tiene en China? Y luego, a la Alegría, a lo largo de la misma línea de lo que estábamos hablando antes, en lugares como China, donde la inteligencia artificial y reconocimiento facial, la tecnología se desarrolla, hay un sesgo similar? Y si es así, ¿qué es? Pero primero, Shalini.

SHALINI KANTAYYA: Bueno, tengo acceso a través de una empresa de fabricación en China. Y siento que esta mujer nos dio la clase de comprensión de este sistema de crédito social que está por venir en China, a donde se está utilizando el reconocimiento facial en tándem con el sistema de crédito social. Por lo tanto, si usted — básicamente, son de un seguimiento, se está viendo que están vigilando a usted, y están puntuación de usted. Y no sólo de lo que hacemos tiene un impacto sobre su puntuación, pero lo que hacen tus amigos impacto en su puntaje. Y esta joven mujer, que yo — que es la que aparece en la película, dice que, como saben, de hecho, no tenemos que confiar en nuestros propios sentidos, que podemos confiar en esta clase de sociales puntuación de crédito para realmente tener integridad en los que podemos confiar y en quien no confiamos. Y creo que, en la película, usted sabe, tenemos suerte de que desee pensar, “Oh, eso es una especie de una galaxia muy, muy lejos de los estados UNIDOS”, Pero que en la realización de esta película, vi todo tipo de parallels de que tipo de puntuación que está pasando aquí en los estados UNIDOS y en otros lugares alrededor del mundo.

NERMEEN SHAIKH: Explicar cómo se ve que es comparable o podría ser.

SHALINI KANTAYYA: Bueno, como Amy Webb dice de manera tan conmovedora en la película, todos estamos siendo anotó todo el tiempo, desde nuestra Súper puntuaciones a nuestro Facebook le gusta. Toda esa información está siendo rastreado y analizado todo el tiempo. Y así estamos todos a ser clasificado todo el tiempo. Y así, ese tipo de seguimiento de impacto cuánto tenemos que pagar por el seguro, ¿qué tipo de oportunidades que se nos muestran en línea. Y así, por mucho que se convierte en una especie de algorítmica determinismo.

AMY GOODMAN: Y la Alegría?

ALEGRÍA BUOLAMWINI:, por Lo tanto, a la pregunta de cómo son los sistemas de trabajo en China, en nuestro primer estudio, llamado “Género Tonos,” nos fijamos en IBM, de Microsoft, pero también nos fijamos en la Cara++, una multimillonaria empresa de tecnología en China. Y encontramos los mismos prejuicios raciales y la discriminación de género. Pero, en general, cuando se han hecho estudios sobre la IA de los sistemas desarrollados en China, estos tienden a funcionar mejor en las caras Chinas, ¿verdad? Y los desarrollados en los países Occidentales tienden a funcionar mejor en las caras Occidentales, así.

Una cosa que yo quería traer relacionados con China y la recopilación de datos es este dato el colonialismo, que estamos empezando a ver. Así que usted tiene informes de las empresas Chinas van a las naciones Africanas, proporcionando el reconocimiento facial o de las tecnologías de vigilancia a cambio de algo muy precioso, los datos biométricos de los ciudadanos. Así que, ahora, en paralelo a lo que teníamos con el comercio de esclavos — a la derecha? — ¿dónde está la extracción de órganos, ahora eres la extracción digital de los cuerpos al servicio de un comercio global, porque incluso cuando se habla de lo que está pasando en Londres, están utilizando la tecnología de una empresa llamada NEC que se basa en el Japón. Así que tenemos que pensar realmente en el contexto global de cómo estas tecnologías extendido por todo el mundo.

SHALINI KANTAYYA: Y solo para agregar a eso, China tiene un acceso sin restricciones a los datos. Ahora se ha ordenado que si desea tener acceso a la internet en China, usted debe presentar para el reconocimiento facial. De modo, que es la base para la que se está construyendo este tipo de sistema de puntuación.

AMY GOODMAN: yo quería ir a otro clip de Codificado Sesgo. Este es el autor del libro Algoritmos de Opresión.

SAFIYA UMOJA NOBLE: de La manera que sabemos acerca de los algoritmos de impacto es mirar los resultados. Por ejemplo, cuando los Estadounidenses se apuesta en contra y seleccionado y optimizado para el fracaso. Así es como buscar un perfil determinado de personas que pueden obtener un hipotecas de alto riesgo y tipo de apuestas en contra de su fracaso y, a continuación, la ejecución respecto a ellos y la aniquilación de su riqueza. Que fue un algorítmica juego que salió de Wall Street. Durante la crisis de las hipotecas, que tuvo la mayor wipeout de negro riqueza en la historia de los Estados unidos. Tan simple como eso. Esto es a lo que me refiero algorítmica de la opresión. La tiranía de estos tipos de prácticas de discriminación han vuelto opaco.

AMY GOODMAN: Que Safiya Noble. Y quiero ir a otro video ahora de Codificado Sesgo, que muestra a una mujer de Filadelfia, que fue sometida a un riesgo de reincidencia algoritmo, que los jueces y los oficiales de libertad condicional que se utilizan para calcular el riesgo de una persona de reincidencia. El sistema de puntuación fue investigado y encontrado para ser racista. Este es Letonia Myers y su abogado, Mark Houldin.

LETONIA MYERS: que me vaya a mi libertad condicional supervisada por la oficina, y ella me dice que tengo que informe una vez a la semana. Yo soy como, “Hold up. ¿Has visto todo lo que acabo de cumplir? Como he estado en casa durante cuatro años. Conseguí un empleo remunerado. Acabo de recibir dos reconocimientos, uno por el Consejo de la Ciudad de Filadelfia, uno de la alcaldía de Filadelfia. Como son en serio va a gustar me puso sobre la presentación de informes cada semana? Para qué? No merezco estar en de alto riesgo de la libertad condicional.”

MARCA HOULDIN: yo estaba en una reunión con el Departamento de libertad Condicional. Eran como ellos, diciendo que tenía este algoritmo, que la etiqueta a la gente de alto, mediano o bajo riesgo. Y entonces, yo sabía que el algoritmo decidido qué nivel de riesgo se fueron.

LETONIA MYERS: Que educó a mí lo suficiente como para volver a mi PO y ser como, “Te refieres a que me digas que no se puede poner en la cuenta de algo positivo que me han hecho para contrarrestar los resultados de lo que este algoritmo está diciendo?” Y ella era como, “No, no hay manera.” Este equipo anuló el discernimiento de un juez y un PO juntos.

MARCA HOULDIN: Y la etiqueta de alto riesgo y que requieren de usted para informar en persona, usted podría haber perdido su trabajo. Y, a continuación, que podría haber hecho usted de alto riesgo.

LETONIA MYERS: que es lo Que duele más, sabiendo que todo lo que he construido hasta ese momento, y todavía estoy mirado como un riesgo. Me siento como todo lo que estoy haciendo es para nada.

AMY GOODMAN: Shalini Kantayya es director de Codificado Sesgo, que clip los clips que hemos jugado. Shalini, como hemos de concluir, ¿qué acerca de la regulación?

SHALINI KANTAYYA: Estos algoritmos están afectando a todos nosotros en la mayoría de los — en nuestros derechos civiles, y necesitamos leyes. Necesitamos legislación significativa alrededor de algoritmos.

AMY GOODMAN: Y la explicación de los algoritmos, en sólo 20 segundos, la Alegría, para nosotros nonscientists?

ALEGRÍA BUOLAMWINI: Sí. Así, los Algoritmos son esencialmente procesos que tienen el propósito de llegar a dar o resolver una tarea en particular. Así, cuando hablamos de AI, estamos hablando de sistemas que puede percibir el mundo, que se puede comunicar y, lo más importante, hacer determinaciones. Y estas determinaciones impacto en nuestras vidas.

AMY GOODMAN: Bueno, queremos darte las gracias por estar con nosotros. La alegría Buolamwini es investigadora en el MIT Laboratorio de Medios de comunicación y fundador de la Algorítmica de la Liga de la Justicia. Vamos a vincular a sus discursos y su testimonio ante el congreso en democracynow.org. Y Shalini Kantayya es el director de la nueva película, que acaba de estrenar aquí en el Festival de Cine de Sundance, llamado Codificado Sesgo.

Y que hace de nuestra emisión. El viernes a las 2 de la tarde, voy a estar hablando aquí, en Park City, Utah, en el museo junto a Dolly la Librería sobre el juicio político y las elecciones. El próximo martes, 4 de febrero, voy a estar en Washington, DC, justo antes de que el Estado de la Unión. Voy a estar entrevistando a Lonnie Montón, director fundador de la Smithsonian, el Museo Nacional de Historia y Cultura afroamericana, a las 6:00 en Busboys y de los Poetas en Washington, DC

Y el próximo viernes, 7 de febrero, al mediodía, Nermeen Shaikh, moderará un panel con la Escuadra de la Universidad de Howard. Alejandría Ocasio-Cortez, Rashida Tlaib, Ilhan Omar y Ayanna Pressley, los cuatro congressmembers, será con Nermeen en la Universidad de Howard, al mediodía, el 7 de febrero. Usted puede ir a todos los detalles en la democracynow.org.

También, la Democracia Ahora! estaremos transmitiendo el Senado de juicio político en democracynow.org. Soy Amy Goodman, con Nermeen Shaikh.

This content was originally published here.

EL 2 DE JUNIO DEL 2024 VOTA PARA MANTENER

TU LIBERTAD, LA DEMOCRACIA Y EL RESPETO A LA CONSTITUCIÓN.

VOTA POR XÓCHITL