los Equipos ahora pueden conducir coches, vencer a los campeones del mundo en juegos de mesa como el ajedrez y el Go, e incluso escribir en prosa. La revolución de la inteligencia artificial se deriva en gran parte de la energía de un tipo particular de red neuronal artificial, cuyo diseño está inspirado por el receptor de capas de neuronas en la corteza visual de mamíferos. Estos “convolucional redes neuronales” (CNNs) han demostrado ser sorprendentemente hábil en el aprendizaje de patrones en dos dimensiones-datos — sobre todo en la visión por ordenador tareas como el reconocimiento de palabras manuscritas y objetos en imágenes digitales.

Pero cuando se aplica a conjuntos de datos sin un built-en la geometría plana — decir, los modelos de formas irregulares utilizada en 3D de animación por ordenador, o las nubes de puntos generadas por la auto-conducción de coches a mapa de su entorno — esta potente máquina de aprendizaje de la arquitectura no funciona bien. Alrededor de 2016, una nueva disciplina llamada geométricas aprendizaje profundo surgió con el objetivo de levantar CNNs de flatland.

Ahora, los investigadores han entregado, con un nuevo marco teórico para la construcción de redes neuronales que pueden aprender los patrones en cualquier tipo de geométrica de la superficie. Estos “indicador equivariant convolucional redes neuronales,” o medidor CNNs, desarrollado en la Universidad de Amsterdam y Qualcomm AI Investigación por Taco Cohen, Maurice Weiler, Berkay Kicanaoglu y Max Welling, pueden detectar patrones no sólo en 2D matrices de píxeles, sino también en los ámbitos y de forma asimétrica objetos curvos. “Este marco es bastante una respuesta definitiva a este problema de aprendizaje profundo sobre superficies curvas,” Welling dijo.

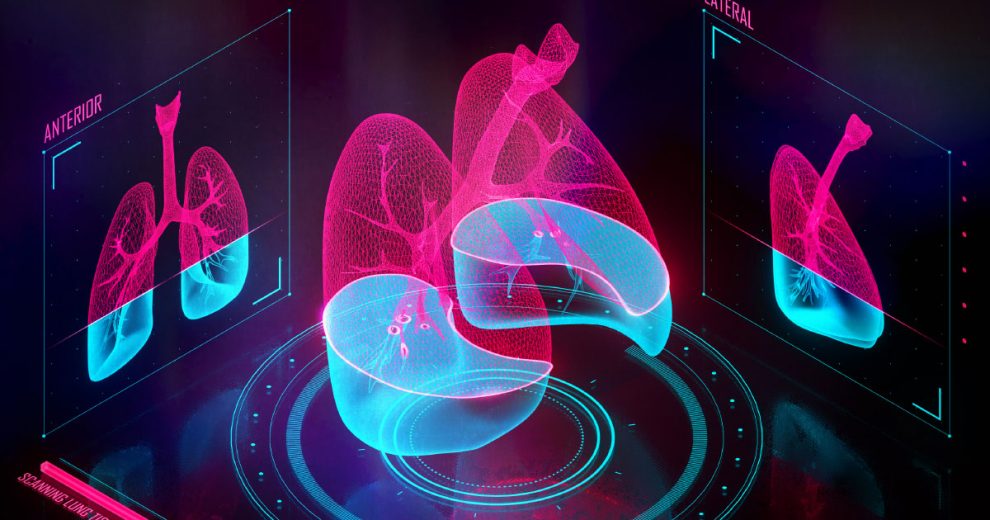

Ya, calibre CNNs de la gran superó a sus predecesores en el aprendizaje de patrones en una simulación global de datos sobre el clima, que es, naturalmente, se asignan sobre una esfera. Los algoritmos pueden ser también de utilidad para mejorar la visión de los aviones no tripulados y vehículos autónomos que ver los objetos en 3D, y para la detección de patrones en los datos recogidos de la forma irregular de las superficies curvas de corazón, cerebro u otros órganos.

Los investigadores solución para conseguir el aprendizaje profundo a trabajar más allá de flatland también tiene profundas conexiones con la física. Las teorías físicas que describen el mundo, como Albert Einstein, la teoría de la relatividad general y el Modelo Estándar de la física de partículas, exhiben una propiedad llamada “calibre equivariance.” Esto significa que las cantidades en el mundo y sus relaciones no dependen arbitraria de los marcos de referencia (o “medidores”); permanecen coherentes si un observador está en movimiento o parado, y sin importar la distancia que los números están en una regla. Las mediciones realizadas en los diferentes medidores deben ser convertibles en cada uno de los otros de una manera que preserve las relaciones subyacentes entre las cosas.

Por ejemplo, imaginar la medición de la longitud de un campo de fútbol en los patios, a continuación, medir de nuevo en metros. Los números van a cambiar, pero de una manera predecible. Del mismo modo, dos fotógrafos de tomar una foto de un objeto desde dos puntos de vista diferentes se producen diferentes imágenes, pero esas imágenes pueden estar relacionados unos con otros. Medidor de equivariance se asegura de que los físicos de los modelos de la realidad consistente, independientemente de su punto de vista o unidades de medida. Y el indicador de CNNs hacer el mismo razonamiento sobre los datos.

“La misma idea de que no hay una orientación especial, querían conseguir que en redes neuronales”, dijo Kyle Cranmer, un físico de la Universidad de Nueva York que se aplica el aprendizaje de máquina para la física de partículas de datos. “Y descubrieron cómo hacerlo.”

Escapar de Flatland

Michael Bronstein, un científico de la computación en el Imperial College de Londres, acuñó el término “geométrica aprendizaje profundo” en 2015 para describir nuevos esfuerzos para bajar de flatland y diseño de redes neuronales que podrían aprender los patrones en no plana de datos. El término — y el esfuerzo de investigación — de pronto cayó en la cuenta.

Bronstein y sus colaboradores sabían que va más allá del plano Euclidiano les obligaría a rediseñar uno de los procedimientos de cálculo que hizo que las redes neuronales de manera efectiva en 2D de reconocimiento de imagen en el primer lugar. Este procedimiento, llamado “convolución” permite que una capa de la red neuronal de realizar una operación matemática en pequeños parches de los datos de entrada y, a continuación, pasar los resultados a la siguiente capa en la red.

“Usted puede pensar de la convolución, a grandes rasgos, como una ventana corrediza,” Bronstein, explicó. Un convolucional de red neuronal de diapositivas muchas de estas “ventanas” a través de los datos como filtros, cada uno diseñado para detectar un cierto tipo de patrón en los datos. En el caso de un gato de la foto, un entrenado CNN puede utilizar filtros en los que se detectan características de bajo nivel en las materias primas píxeles de entrada, tales como bordes. Estas características se pasan a las otras capas de la red, que realizan adicionales circunvoluciones y extracto de alto nivel de características, como los ojos, la cola o las orejas triangulares. CNN entrenados para reconocer los gatos se utilice en última instancia los resultados de estas capas de circunvoluciones para asignar una etiqueta de decir, “gato” o “gato” — a toda la imagen.

Pero ese método sólo funciona en un avión. “Como la superficie sobre la que se desea hacer el análisis se vuelve curvo, entonces usted está básicamente en problemas”, dijo Welling.

Realizar una convolución en una superficie curva conocida en la geometría como un colector — se parece mucho a la celebración de un pequeño cuadrado de translúcido papel de gráfico a través de un globo y tratando de precisión de seguimiento de la costa de Groenlandia. No se puede presionar la plaza en Groenlandia sin arrugando el papel, lo que significa que su dibujo será distorsionado al apoyarlo completamente nuevo. Pero la celebración de los cuadrados de papel de la tangente al globo en un punto y el seguimiento de Groenlandia borde, mientras que mirando a través del papel (una técnica conocida como la proyección de Mercator) se producen distorsiones demasiado. Alternativamente, usted puede colocar su papel cuadriculado en un mundo plano, mapa, en lugar de un globo, pero, a continuación, que acaba de ser replicar esas distorsiones — como el hecho de que todo el borde superior del mapa representa en realidad a un solo punto en el globo (el Polo Norte). Y si el colector no es una casa esfera como un globo, pero algo más complejo o irregulares como la forma 3D de una botella, o una proteína plegada, haciendo de convolución en que se hace aún más difícil.

Bronstein y sus colaboradores encontraron una solución para el problema de la convolución sobre los no-Euclidiana colectores en 2015, por la reinvención de la ventana deslizante como algo más modelada como una circular en la telaraña de un pedazo de papel cuadriculado, para que presione contra el mundo (o cualquier superficie curva) sin fruncir, estiramiento o desgarro de ella.

el Cambio de las propiedades de la corredera del filtro en este modo, el CNN mucho mejor en la “comprensión” de ciertas relaciones geométricas. Por ejemplo, la red puede reconocer automáticamente que una forma 3D doblada en dos poses diferentes — como una figura humana de pie y una figura humana, la elevación de una pierna — fueron instancias del mismo objeto, en lugar de los dos completamente diferentes objetos. El cambio también hizo que la red neuronal mucho más eficiente en el aprendizaje. Estándar CNNs “millones de ejemplos de las formas de entrenamiento de semanas,” dijo Bronstein. “Hemos utilizado algo como 100 formas en diferentes poses y entrenado para tal vez una media hora.”

al mismo tiempo, Taco Cohen y sus colegas en Amsterdam se aproxima el mismo problema desde la dirección opuesta. En 2015, Cohen, un estudiante graduado en el tiempo, no era el estudio de cómo levantar el aprendizaje profundo de flatland. Más bien, él estaba interesado en lo que él pensaba que era una práctica de la ingeniería problema: datos de la eficiencia, o cómo entrenar las redes neuronales con menos ejemplos de los miles o millones de personas que a menudo se requiere. “En lo profundo de los métodos de aprendizaje son, digamos, muy lento estudiantes,” dijo Cohen. Esto plantea algunos problemas si eres de formación de CNN para reconocer, dicen, los gatos (dado el abismo de suministro de imágenes de gatos en internet). Pero si desea que la red detecte algo más importante, como los nódulos cancerosos en las imágenes de tejido pulmonar, a continuación, encontrar suficientes datos de entrenamiento — que debe ser médicamente exacta, debidamente etiquetados, y libre de problemas de privacidad — no es tan fácil. El menor número de ejemplos necesarios para capacitar a la red, mejor.

Cohen sabía que una manera de aumentar los datos de la eficiencia de una red neuronal sería dotarlo de ciertas suposiciones acerca de los datos de antemano — como, por ejemplo, que un tumor de pulmón es todavía un tumor de pulmón, incluso si se gira o se refleja en una imagen. Por lo general, un convolucional de la red tiene que aprender esta información desde el principio por la formación en muchos de los ejemplos de el mismo patrón en diferentes orientaciones. En 2016, Cohen y Welling co-autor de un papel de la definición de cómo codificar algunos de estos supuestos, en una red neuronal como geométricas, simetrías. Este enfoque funcionó tan bien, que en el año 2018, Cohen y co-autor Marysia Winkels había generalizado aún más, mostrando resultados prometedores en el reconocimiento de cáncer de pulmón en TC: Su red neuronal podría identificar la evidencia visual de la enfermedad, utilizando sólo una décima parte de los datos utilizados para entrenar a otras redes.

Amsterdam investigadores mantienen en la generalización. Que cómo se encuentra su manera de medir equivariance.

Ampliación de Equivariance

la Física y el aprendizaje de máquina tienen una base de similitud. Como Cohen puso, “Ambos campos están preocupados con la formulación de observaciones y, a continuación, la construcción de modelos para predecir las futuras observaciones.” Crucialmente, señaló, tanto en los campos de buscar los modelos de las cosas individuales — no es bueno tener una descripción de los átomos de hidrógeno y otro de boca abajo a los átomos de hidrógeno — pero de las categorías generales de las cosas. “La física, por supuesto, ha sido muy buena en eso.”

Equivariance (o “covarianza”, el término que los físicos prefieren) es la suposición de que los físicos desde Einstein han invocado para generalizar sus modelos. “Simplemente significa que si usted está describiendo algunas de física de la derecha, entonces debe ser independiente de qué tipo de ‘gobernantes’ que usted use, o más en general, ¿qué tipo de observadores que son”, explicó Miranda Cheng, un físico teórico en la Universidad de Amsterdam, que escribió un libro con Cohen y otros, la exploración de las conexiones entre la física y el indicador de CNNs. O como el mismo Einstein puso en 1916: “Las leyes generales de la naturaleza se expresan por medio de ecuaciones que tener bueno para todos los sistemas de coordenadas.”

Convolucional redes se convirtió en uno de los métodos más exitosos en el aprendizaje profundo por la explotación de un simple ejemplo de este principio se llama “traducción equivariance.” Una ventana de filtro que detecta una determinada característica en una imagen — por ejemplo, los bordes verticales de la voluntad de la diapositiva (o “traducir”) sobre el plano de píxeles y codificar las ubicaciones de todos los bordes verticales; a continuación, se crea una función “mapa” que marcan estos lugares y pasa a la siguiente capa en la red. La creación de los mapas de características es posible debido a la traducción equivariance: La red neuronal que “se supone” que la misma función puede aparecer en cualquier lugar en el plano 2D y es capaz de reconocer un borde vertical como un borde vertical ya sea en la esquina superior derecha o la esquina inferior izquierda.

“el punto sobre La equivariant redes neuronales es tomar estos evidente simetrías y los pone en la arquitectura de la red, de modo que es una especie de almuerzo gratis”,” Weiler dijo.

en el año 2018, Weiler, Cohen y su doctorado supervisor Max Welling había extendido este “almuerzo gratis” para incluir otros tipos de equivariance. Su “grupo-equivariant” CNNs podría detectar girar o reflejar las características en el plano de las imágenes sin tener que formar en los ejemplos específicos de las características de estas orientaciones; esférica CNNs podría crear mapas de características a partir de datos de la superficie de una esfera sin distorsionar como plano de las proyecciones.

Estos enfoques aún no estaban lo suficientemente general como para manejar los datos en colectores con el lleno de baches, irregularidades de la estructura que describe la geometría de casi todo, de patatas a las proteínas, a los cuerpos humanos, a la curvatura del espacio-tiempo. Estos tipos de colectores no tienen “global” de la simetría para una red neuronal para hacer equivariant suposiciones acerca de: Cada lugar es diferente.

El reto es que el deslizamiento de un plano de filtro sobre la superficie puede cambiar la orientación del filtro, dependiendo del camino que toma. Imagina un filtro diseñado para detectar un patrón simple: un oscuro blob en la izquierda y un poquito de blob en la derecha. Deslícelo hacia arriba, abajo, izquierda o derecha en un piso de rejilla, y que siempre estará del lado derecho. Pero incluso en la superficie de una esfera, esto cambia. Si mueve el filtro de 180 grados alrededor de la esfera del ecuador, el filtro de la orientación de las estancias de la misma: el lado oscuro de blob en la izquierda, la luz de blob en la derecha. Sin embargo, si usted deslícela hacia el mismo lugar por el que se mueve sobre la esfera del polo norte, el filtro está al revés — oscuro blob a la derecha, la luz de blob en la izquierda. El filtro no detecta el mismo patrón en los datos o codificar la misma función de mapa. Mover el filtro de alrededor de un proceso más complejo, múltiple de admisión, y podría terminar apuntando en cualquier número de incoherencia de las direcciones.

por Suerte, los físicos desde que Einstein se han enfrentado con el mismo problema y encontrar una solución: calibre equivariance.

La clave, explica Welling, es olvidarse de mantener un seguimiento de cómo el filtro de la orientación de los cambios a medida que se mueve a lo largo de diferentes caminos. En su lugar, usted puede elegir un filtro de orientación (o calibre) y, a continuación, definir de forma coherente, de la conversión de todos los demás de la orientación en él.

El problema es que mientras que cualquier medidor se puede utilizar en una orientación inicial, la conversión de otros medidores en ese marco de referencia debe conservar el patrón subyacente — como la conversión de la velocidad de la luz de metros por segundo a kilómetros por hora debe preservar el subyacente físico en la cantidad. Con este medidor de equivariant enfoque, dijo Welling, “el número real de cambio, sino que cambian completamente en una manera predecible.”

Cohen, Weiler y Welling codificado calibre equivariance — el último de los “almuerzo gratis” — en sus convolucional de la red neuronal en el 2019. Ellos hicieron esto mediante la colocación de matemática restricciones sobre lo que la red neuronal se podía “ver” en los datos a través de sus circunvoluciones; sólo el indicador de equivariant patrones se pasa a través de la red de capas. “Básicamente, usted puede darle a cualquier superficie” — Euclidiana de los aviones de la arbitrariedad de objetos curvos, incluyendo exóticos colectores como Klein o botellas de cuatro dimensiones del espacio-tiempo “y es bueno para hacer el aprendizaje profundo en la superficie”, dijo Welling.

Una Teoría de Trabajo

La teoría de gauge-equivariant CNNs es tan generalizada que se incorpora automáticamente el construido-en los supuestos de los anteriores geométricas profunda de los enfoques de aprendizaje como de rotación equivariance y cambio de filtros en las esferas. Incluso Michael Bronstein del método anterior, en la que las redes neuronales reconocer una sola forma 3D doblada en diferentes poses, encaja dentro de ella. “Calibre equivariance es muy amplio marco. Contiene lo que hicimos en el año 2015 como configuración particular,” dijo Bronstein.

Un medidor de CNN sería teóricamente el trabajo en cualquier superficie curva de cualquier dimensión, pero Cohen y sus co-autores han probado en el clima global de los datos, que necesariamente ha subyacente 3D estructura esférica. Ellos usaron su calibre equivariant marco para construir un CNN entrenados para detectar patrones climáticos extremos, como los ciclones tropicales, a partir de la simulación del clima de datos. En 2017, el gobierno y los investigadores académicos se utiliza un estándar de convolucional de la red para detectar los ciclones en los datos con el 74% de precisión; el año pasado, el indicador de la CNN detectado los ciclones con el 97.9% de precisión. (También se impuso a menos general geométricas profundo enfoque de aprendizaje diseñado en 2018 específicamente para las esferas — que el sistema fue de 94% de precisión.)

Mayur Mudigonda, un científico del clima en el Laboratorio Nacional Lawrence Berkeley que utiliza el aprendizaje profundo, dijo que va a seguir prestando atención a calibre CNNs. “Ese aspecto de la humana inteligencia visual” — patrones de manchas con precisión, independientemente de su orientación — “es lo que nos gustaría que se traducen en el clima de la comunidad”, dijo. Qualcomm, un fabricante de chips que recientemente contrató a Cohen y Welling y adquirió un inicio se construyó la incorporación de sus primeros trabajos en equivariant redes neuronales, es ahora la planificación de aplicar la teoría de gauge CNNs para desarrollar mejores aplicaciones de visión por computador, como un avión no tripulado que puede “ver” en 360 grados a la vez. (Este ojo de pez visión del mundo puede ser naturalmente proyecta sobre una superficie esférica, como clima global de datos.)

Mientras tanto, el indicador CNNs están ganando terreno entre los físicos como Cranmer, que los planes para ponerlos a trabajar en los datos de las simulaciones de las interacciones entre partículas subatómicas. “Estamos analizando los datos relacionados con la fuerza fuerte, tratando de entender lo que está pasando en el interior de un protón,” Cranmer, dijo. Los datos de cuatro dimensiones, él dijo, “así que tenemos un caso de uso perfecto para las redes neuronales que tienen este calibre equivariance.”

Risi Kondor, un ex físico que ahora los estudios equivariant redes neuronales, dijo que el potencial de las aplicaciones científicas de calibre CNNs puede ser más importante que sus usos en la IA.

Si usted está en el negocio de reconocimiento de gatos en YouTube y descubres que no eres tan bueno en reconocer al revés de los gatos, que no es grande, pero tal vez se puede vivir con ella”, dijo. Pero para los físicos, es crucial para asegurarse de que una red neuronal no permite errores en la identificación de un campo de fuerza o trayectoria de la partícula debido a su orientación particular. “No es sólo una cuestión de conveniencia,” Kondor — dijo – “es esencial que el subyacente simetrías ser respetados.”

Pero mientras los físicos en matemáticas ayudó a inspirar calibre CNNs, y los físicos pueden encontrar un amplio uso para ellos, Cohen señaló que estas redes neuronales no ser el descubrimiento de alguna nueva física de los mismos. “Ahora somos capaces de diseñar redes que puedan proceso muy exóticos tipos de datos, pero usted tiene que saber cuál es la estructura de los datos es” de antemano, dijo. En otras palabras, la razón por la que los físicos pueden utilizar calibre CNNs es porque Einstein había demostrado que el espacio-tiempo puede ser representada como una de cuatro dimensiones curvas de colector. Cohen red neuronal no ser capaz de “ver” que la estructura en su propio. “El aprendizaje de las simetrías es algo que no puede hacer”, dijo, aunque él espera que será posible en el futuro.

Cohen no puede ayudar pero se deleitan en las conexiones interdisciplinarias que él una vez que ya intuía y ahora se ha demostrado con rigor matemático. “Siempre he tenido la sensación de que el aprendizaje de máquina y la física están haciendo cosas muy parecidas”, dijo. “Esta es una de las cosas que me parece realmente admirable: empezamos con este problema de ingeniería, y como empezamos la mejora de nuestros sistemas, poco a poco se desvela a más y más conexiones.”

Corrección: 9 de enero de 2020

El artículo fue revisado a la nota que calibre CNNs se desarrollaron en el estadio IA de Investigación así como de la Universidad de Ámsterdam.

This content was originally published here.

EL 2 DE JUNIO DEL 2024 VOTA PARA MANTENER

TU LIBERTAD, LA DEMOCRACIA Y EL RESPETO A LA CONSTITUCIÓN.

VOTA POR XÓCHITL