Anónimo AI viene

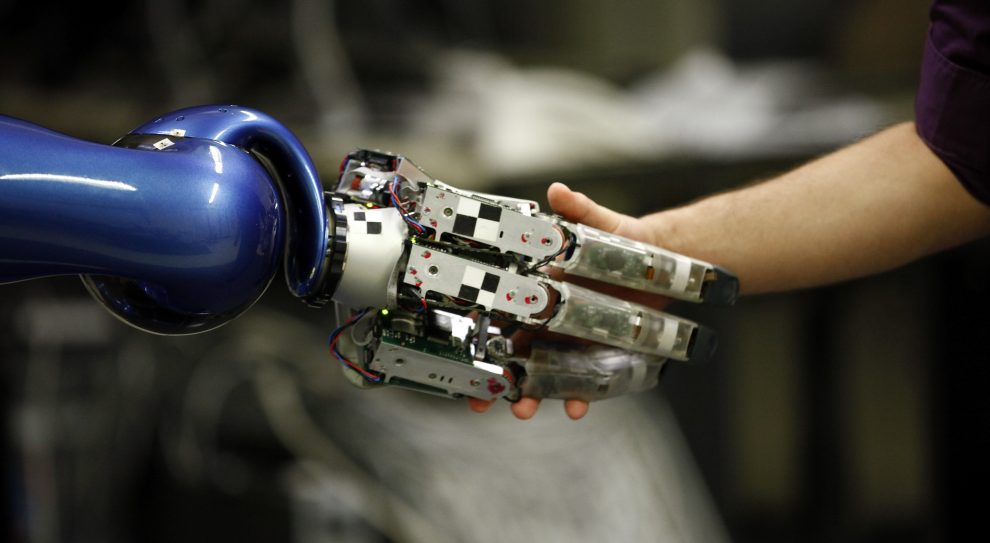

Nos estamos acercando a una nueva era de la omnipresente AI. Entre nuestros smartphones, ordenadores, coches, casas, internet de las cosas, y medios de comunicación social, el ciudadano medio de los países desarrollados podrían interactuar con algún tipo de sistema de IA docenas de veces cada día. Muchas de estas aplicaciones será muy útil. Todo el mundo le dará la bienvenida mejor servicio al cliente automatizado, donde se puede recibir información precisa y exhaustiva de las respuestas a las preguntas acerca de temas complejos. Por ejemplo, pronto, podría ser fácil para los AI para transmitir lo que su seguro de salud cubre, basado en una base de datos de similar a los acreedores anteriores.

Para la mayoría de estas interacciones, será, obviamente, y con intención clara de que el texto que leer, voz que se oye, o la cara que se ve no es una persona real. Sin embargo, otras veces no es tan obvio. Como AI tecnologías de forma rápida y metódicamente a salir de la uncanny valley, servicio al cliente de llamadas, página web chatbots, y de las interacciones en los medios sociales y en la realidad virtual puede ser progresivamente menos evidentemente artificial.

Turing pruebas se producirá la prueba del tiempo

ahora Hemos eclipsado el año en el que la distópico 1982 película de ciencia ficción “Blade Runner” es el conjunto de 2019. En una pertinente escena, el protagonista, interpretado por Harrison Ford, realiza un elaborado el test de Turing en un aparente carácter humano, Rachael. Durante varias horas y más de un centenar de preguntas, que es finalmente la que determina que Rachael es un AI—aunque de una manera impresionante y realista de uno. Mientras la perfección la forma humanoide de Rachael mucho outshoots la tecnología moderna, todavía hay un aspecto profético de esta interacción. El problema que tenemos no es que la IA es tan convincente que un compromiso de la persona no puede identificar como sintético. En cambio, el problema es que el tiempo necesario para hacerlo es prohibitivo.

“El problema que tenemos no es que la IA es tan convincente que un compromiso de la persona no puede identificar como sintético. En cambio, el problema es que el tiempo necesario para hacerlo es prohibitivo.”

en la Actualidad, razonablemente una persona motivada puede no tener tantos problemas descubriendo una AI impostor en la conversación—aunque sólo la mitad de los Estadounidenses piensan que podría identificar a un bot en los medios sociales.1 Incluso el mejor de procesamiento de lenguaje natural (PLN) modelos, tendrá que luchar con la repetición, mostrar irregularidades en la coherencia entre las oraciones, y tienen problemas con los modismos y la gramática. Sin embargo, estas AI modelos están mejorando muy rápidamente. Una serie de vanguardia de los modelos lanzados por los laboratorios de investigación como el Instituto Allen para la IA, Google AI, y OpenAI están empujando el estado del campo. Se puede escribir gráfico historias2 y ayudar en la fórmula de informes de noticias como las que se encuentran en los deportes y finanzas de la cobertura.3 Que también se están empezando a aprender a debate de manera competente.4 El Duque Reporteros de Laboratorio es aún la esperanza de que AI se puede verificar en tiempo real5—un paso crítico para actuar believably humanos. Mientras que muchos de sus defectos persisten, los sistemas de AI no tiene que ser perfecta para ser convincente. Ellos sólo necesitan ser lo suficientemente bueno para tomar ventaja de un ocupado y distraído persona.

En algunas circunstancias, estos modelos pueden ser tan convincentes que han generado un debate acerca de cómo, e incluso si, deben ser liberados. A diferencia de gran parte de la academia, la liberación de un modelo significa más que sólo hacer pública una metodología y trabajo de investigación. Estos modelos de la PNL son entrenados en un gran número de documentos (creo que todos los de la Wikipedia y, a continuación, algunos) utilizando enorme poder de computación. Luego son liberadas con que toda interpretación de un idioma se guarda dentro. Esto significa que cuando un nuevo modelo de la PNL se hace público, cualquier semi-desarrollador competente puede adoptar directamente para su propósito específico, sin que el origen de datos o costoso hardware de computación.

Esto es una gran ayuda para las aplicaciones que beneficien a la sociedad (por ejemplo, automatizado con subtítulos y traducción de idiomas), como los esfuerzos de beneficiarse de la última tecnología. También informa de por qué los errores y sesgos de estos modelos puede ser tan importante, ya que se perpetran a través de aplicaciones posteriores.6 por supuesto, estos modelos también pueden ser utilizados para mal. Investigadores de la Universidad de Middlebury demostrado que OpenAI modelo más nuevo, GPT-2, puede generar propaganda en la escala de puntos de vista extremistas, como la supremacía blanca y el yihadismo.7

El costo de anónimo AI en el comercio

por Desgracia, las empresas se van a encontrar muchas razones para duplicitously presentar su software como personas reales. Ellos deciden que sus productos, anuncios, o los esfuerzos de ventas va a obtener más atención y tiempo si se percibe como proveniente de una persona. Tomemos, por ejemplo, de Google, Dúplex, AI-teléfono con asistente que puede llevar a cabo conversaciones para llevar a cabo tareas como hacer una reserva en el restaurante. En el lanzamiento de Duplex, Google ha optado por un sistema de lo más realista a la voz humana como posible, que claramente evitó revelar a sí mismo como de software, y sólo se revierte supuesto, bajo presión de la opinión pública. Muchos menos prominentes que las empresas no estarán sujetos a la misma crítica, o pueden optar por ignorar.

Un reciente experimento aleatorio mostró que cuando los chatbots no revelar sus automatizado de la naturaleza, que superó sin experiencia vendedores.8 Pero cuando el chatbot se reveló a sí mismo, su rendimiento de ventas reducido en un 80%. Independientemente de si el futuro de la investigación corrobora esta conclusión, incluso una pequeña cantidad de evidencia de que el anonimato ayuda a las ventas que puede convencer a muchas empresas a no revelar su AI.

“[E]ven una pequeña cantidad de evidencia de que el anonimato ayuda a las ventas que puede convencer a muchas empresas a no revelar su AI.”

las Empresas también utilizan dirigida patrocinios de medios de comunicación social personalidades, especialmente evidente en Instagram, para vender sus marcas. Ya hay una pequeña industria artesanal de la creación de la celebridad chatbots que están destinados a reflejar el estilo de escritura de un personaje famoso.9 Como estas a mejorar, sería sorprendente ver automatizado de las interacciones entre las estrellas de internet y a sus fans con la intención de impulsar las ventas de pseudocientífico suplementos para la salud y caro athleisure marcas? Es, probablemente, está ocurriendo ya.

Uno puede disfrutar de pedido en Domino’s Pizza de su chatbot, Dom,10 o conseguir ayuda en la elección de una temporada de franela de American Eagle chatbot,11 pero ¿qué pasa cuando no está claro si el asesoramiento financiero de un robot? Es ingenuo pensar que estos sistemas están diseñados exclusivamente para informar a los clientes—que están destinadas a cambiar el comportamiento, especialmente hacia gastar más dinero. A medida que la tecnología mejora y los conjuntos de datos se expanda, que serán más eficaces para este fin. Los clientes deben, al menos, tienen el derecho a saber que esta influencia viene de un sistema automatizado.

Las mismas inquietudes que surgen en otros sectores, tales como la telemedicina software.12 un Reciente estudio de Brookings del Programa de Política Metropolitana deja en claro que la IA va a ampliar en muchos aspectos de nuestra sociedad y nuestra economía. Las consecuencias de anónimo AI puede ser muy extenso.

El costo de anónimo AI en la política

En el año 2017, el período de comentarios públicos de la Comisión Federal de Comunicaciones (FCC) propuesta de revocación de la neutralidad de la red recibió más de 24 millones de comentarios. Este rompieron el récord anterior de 4 millones de comentarios y se estrelló en el sitio web de la FCC. Mientras que el nivel de interés público en esta regla era bastante alto, millones de estos comentarios resultó ser generados automáticamente con falsos o robo de información personal—a veces con los nombres de los fallecidos. Buzzfeed News más tarde descubrieron que el grupo de la industria de banda ancha para América estaba detrás de la fraudulenta de las campañas, la creación de millones de comentarios en contra de la neutralidad de la red.13 estudios Independientes, sin embargo, sugieren que la inmensa mayoría de los comentarios reales fueron en favor de la preservación de la neutralidad de la red.14 Buzzfeed también identificado similar el “astroturf” campañas de pro-elección de las políticas de educación en Texas y en favor del Oleoducto Keystone, pero es difícil saber exactamente cómo omnipresente de este problema.

“a Pesar de la afirmación de que los medios de comunicación social bots son responsables de balanceo de las principales elecciones es probablemente exagerada, que están teniendo un impacto.”

La escala de AI compromiso político en los medios de comunicación social, se entiende mejor. Un estudio reciente estima que el 12,6% de los políticamente comprometidos cuentas de Twitter son robots automatizados—más o menos sin cambios desde el año 2016.15 Durante las elecciones presidenciales de 2016, otro estudio estima que el 20% de todos los tweets vino de bots.16 a Pesar de la afirmación de que los medios de comunicación social bots son responsables de balanceo de las principales elecciones es probablemente exagerada, están teniendo algún impacto. Un documento de trabajo en el estudio de Brexit y el 2016 las elecciones ESTADOUNIDENSES encontraron evidencias claras de que los robots han contribuido a los políticos de la cámara de eco y amplificación de la polarización.17 Aún más la investigación mostró que en línea de la crítica de los asediados el Presidente de Venezuela, Nicolás Maduro aumentó después de que la desactivación de los miles de pro-Maduro Twitter bots.18 los Robots también se han observado promover peligrosa pseudociencia campañas, como aquellos en contra de la MRR vacuna.19

en la Actualidad, Twitter permite a los bots en el sitio web si no violar las reglas como la plataforma de la manipulación y de la política de spam.20 Twitter se merece algo de crédito por sus acciones contra coordinado campañas de desinformación, tales como los que se originan en Rusia, Irán, Venezuela,21 y Arabia Saudita,22 así como la fabricación de una cantidad significativa de sus datos a los investigadores.23 para Que sus datos estén disponibles es por eso que el alcance del problema es relativamente bien entendido de que, en comparación con otras plataformas digitales como YouTube, Facebook, Instagram y WhatsApp.

no obstante, hay algunos académicos evidencia de que Twitter podría ser más rápido en la eliminación de los tratos inhumanos cuentas que violan sus reglas.24 Además, que en la actualidad no hacen ningún esfuerzo para etiquetar los bots si no se violen de Twitter reglas—ninguna de las plataformas digitales de hacer. Esto a pesar de que un cambio en una de 2018 Comité de Inteligencia del Senado de la audiencia en la que tanto Facebook y Twitter sugirió que iban a trabajar hacia el bot de la divulgación.25

Los medios de comunicación social las empresas tienden a argumentar que estos problemas son difíciles desde un punto de vista técnico. Cuando se enfrentan con la investigación acerca de las posibles soluciones, a menudo se dice que la investigación se realizó en los ambientes académicos y no refleja su mayor escala que se aplica a las circunstancias. Probablemente esto es parcialmente cierto, aunque no se muestra públicamente en evidencia. Una diferencia en los incentivos también conduce a esta diferencia de opiniones, incluso un pequeño número de falsos positivos, en los que un usuario real tiene una cuenta afectados por el bot de detección, es perjudicial para las plataformas. Tomando nota de esto, los investigadores abogan por un proceso en el que los revisores evalúan cuentas como sospechoso por los análisis automatizados.26

Dadas las consecuencias y su reticencia a la ley, que requiere que las principales plataformas digitales de hacer un sostenido y de los esfuerzos razonables para cumplir bot divulgación no es pedir demasiado. Un requisito legal también pone algo de la responsabilidad recae directamente en las empresas y las campañas políticas a sí mismos, haciendo las plataformas menos unilateralmente responsable y la posibilidad de dar más datos para ayudar a perfeccionar sus bot esfuerzos de detección para los actores menos probabilidades de las reglas de juego (Rusia).

Los beneficios de la transparencia de la AI

AI divulgación resulta ser la fruta madura en el típico complejo de zarza de la política de la tecnología. Por desgracia, no va a evitar el abuso de estos modelos en las campañas de propaganda terrorista extranjera, o la desinformación. Puede, sin embargo, reducir la exposición a la engañosa política y comercial de las aplicaciones descritas en este documento, y hay otros beneficios.

“[I]ndividual será la toma de decisiones mejora cuando las personas saben que están interactuando con un sistema de IA. Ellos pueden hacer juicios acerca de las ventajas y limitaciones del sistema, a continuación, elija si desea trabajar con él o buscar ayuda humana.”

Por ejemplo, la decisión individual se mejora cuando las personas saben que están interactuando con un sistema de IA. Ellos pueden hacer juicios acerca de las ventajas y limitaciones del sistema, a continuación, elija si desea trabajar con él o buscar la ayuda humana. Ahora mismo, muchas personas no saben cómo interactuar con un moderno sistema de IA, para alcanzar mejor sus objetivos. Sin embargo, esto puede ser aprendido a través de la exposición repetida.

puede tomar muchas de las interacciones de la gente a comprender lo que un sistema de inteligencia artificial que puede y no puede hacer. El tipo de IA que está en funcionamiento hoy en día es llamado “estrecho de AI,” lo que significa que puede funcionar muy bien en algunas tareas, mientras que siendo totalmente infantil en los demás. Es muy lejos de la “AI” que llena nuestra cultura—hay que pensar en la TELEVISIÓN y en películas como “El Mundo”, “Battlestar Galactica,” “Ex Machina”, y por supuesto, “Blade Runner.” La gente drásticamente puede sobrestimar de IA capacidad al oír su respuesta a cada pregunta técnica, sin darse cuenta de que no puede entender el contexto único de su situación cuando un reembolso está garantizado por una empresa de error.

a partir De un menor punto de vista normativo, AI la transparencia puede ayudar a los humanos a dirigir su sinceridad principalmente hacia las personas, no robots. Cuando un host en un restaurante se enfrenta con un cliente de pie en frente de ellos y de IA asistente de sonar el teléfono, no habrá ambigüedad—la real persona puede obtener un trato preferencial. Es lo bastante duro del mundo, y debemos preservar la compasión por los seres humanos que pueda apreciar.

Edificio en el “Blade Runner” proyecto de ley

California legislatura del estado ya ha pasado el Refuerzo en Línea de la Transparencia (BOT), la ley, el apodo de “Blade Runner” proyecto de ley. Esta legislación requiere que los robots que operan en internet a revelar por sí mismos incentivar la realización de una transacción comercial o influencia de una elección.27 en particular, la legislación que específicamente se exime a las empresas de medios sociales de cualquier responsabilidad. Mientras que un proyecto de ley que sólo impide que las empresas nacionales y las campañas de uso subrepticio los sistemas de AI tiene mérito suficiente, tanto de las más nefastas de IA actividad está dirigida a las plataformas digitales. Esta es la razón por la Senadora Dianne Feinstein, D-Calif., se ha introducido una legislación federal que requieren de medios de comunicación social a las empresas a cumplir bot requisitos de divulgación (en adición a la prohibición de las entidades políticas de uso de AI a imitar a las personas).28

El Congreso de estados UNIDOS debe aprobar legislación que combina estas propuestas, poniendo una carga de IA divulgación de información en las empresas y de los actores políticos, mientras que también exigen un esfuerzo razonable para la etiqueta de bots por las plataformas digitales. Debe incluir multas serán asignados por la Comisión Federal de Comercio para comerciales y violaciones de la Comisión de Elecciones Federales para la política infracciones; que estos organismos son imperfectos opciones para esta tarea puede ser añadido a la letanía de razones para considerar una nueva tecnología de la agencia reguladora. Aunque los productos comerciales que vienen con los sistemas de AI, como Siri de Apple y Amazon, Alexa, no son una preocupación, la ley de la jurisdicción no debe ser estrictamente limitado a la internet. Hay muchas circunstancias que podemos comenzar a encontrar de AI, y no todos ellos serán estrictamente en la web.

“[S]esde ahora sólo estamos en la primera década de la moderna AI, podemos encontrar a nosotros mismos, especialmente agradecido por el establecimiento de un estándar de transparencia por razones que no son evidentes hoy en día.”

Hay un valor inmediato a una amplia requisito de AI-divulgación: reducir el fraude, la preservación de la compasión humana, la educación del público, y la mejora en el discurso político. Y puesto que ahora sólo estamos en la primera década de la moderna AI, podemos encontrar a nosotros mismos, especialmente agradecido por el establecimiento de un estándar de transparencia por razones que no son evidentes hoy en día.

La Institución Brookings es una organización sin fines de lucro dedicada a la investigación independiente y soluciones políticas. Su misión es llevar a cabo de alta calidad, independiente y de investigación, basado en la investigación, para proporcionar innovadores, prácticos recomendaciones para la formulación de políticas y el público. Las conclusiones y recomendaciones de cualquier Brookings publicación son de exclusiva responsabilidad de su autor(s) y no reflejan los puntos de vista de la Institución, sus directivos, o sus otros estudiosos.

Microsoft proporciona soporte técnico a La Institución Brookings de la Inteligencia Artificial y las nuevas tecnologías (AIET) Iniciativa, y Amazon, Apple, Facebook, Google, y proporcionar general, el apoyo irrestricto a la Institución. Los hallazgos, interpretaciones y conclusiones en este informe no están influenciados por la donación. Brookings reconoce que el valor que aporta es, en su absoluto compromiso con la calidad, la independencia y el impacto. Actividades con el apoyo de sus donantes reflejan este compromiso.

This content was originally published here.

EL 2 DE JUNIO DEL 2024 VOTA PARA MANTENER

TU LIBERTAD, LA DEMOCRACIA Y EL RESPETO A LA CONSTITUCIÓN.

VOTA POR XÓCHITL